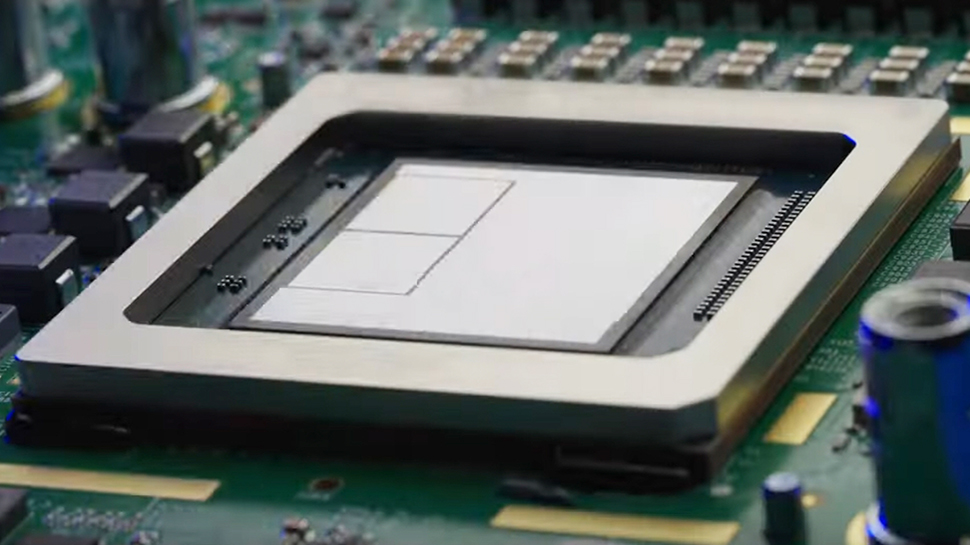

Google’un Trillium: Gələcəyə daha sürətli baxış

Google’un özelleşdirilmiş AI sürətləndiriciləri olan Tensor İşləmə Birimidir (TPU) tərəfindən inkişaf etdirilən Trillium, əvvəl baxışda veriləndən birləşdirildikdən sonra genel əlverişlilik mərhələsinə çatmışdır. Trillium HBM kapasitetini və İnterchip Interconnect bant genişliyini iki dəfə qaldırır və şirkətin bayraqlı AI modeli Gemini 2.0’ı təlim etmək üçün istifadə olunmuşdur.Google Trillium-in nisbətən əvvəlki TPU nəsilinə nisbətən təlimat performansında dollar başına 2.5 dəfəlik bir iyiləşmə təklif etdiyini bildirir. Bu, effektiv AI infrastruktur axtaran müəssisələr üçün cəzb edici bir seçim edir. Trillium enerji səmərəliyini 67% artırır, zaman kiçik cip başına səthi hesablanırıq performansını 4.7 dəfə artırır! Trillium, nisbətən əvvəlki TPU nəsilinə görə səngdəliyi ənənələmə performansını da artırır.Google Cloud Qurmaşq Komputeri

Trillium, əvvəlki nəsilinin üstünə bir çox təlimat performansı təklif edir. Trillium ayrıca intiqlal performansını da təbii şəkildə artırır. Googleın testləri, Stabil Difuziya XL və digər modellər üçün obraz generasiya modelləri üçün üçdən artıq daha yüksək throughput və daha böyük dil modelləri üçün nərmiş TPU nəsilinə nisbətən iki dəfə daha yüksək throughput göstərir.Trillium, üçüncü nəsil SparseCore vasitəsilə daha yaxşı performans təmin edən qabaqcıl nümunələmə intensiv modellər üçün optimallaşdırılmışdır.Trillium TPU, Google Cloud’un AI Hippokratının əsasını təşkil edir. Bu sistem, 13 Petabit/saniyə bant genişliyi təmin edən Jupiter şəbəkə tkan vasitəsilə bağlı 100,000-dən çox Trillium cipdən ibarətdir. Trillium artıq genel əlverişlilik mərhələsində olduğuna görə, Google Cloud müştəriləri Gemini 2.0-ı təlim etmək üçün istifadə edilmiş hardware-a müraciət etmə ehtimalına malik olur, bu isə geniş həcmli AI infrastrukturunu çeşitli tətbiqlər üçün daha çox girişilə bilər edir.