Der Schöpfer des schnellsten KI-Chips der Welt – DeepSeek Onboarding stört die KI-Welt

Der Schöpfer des schnellsten KI-Chips der Welt sorgt mit DeepSeek Onboarding für Aufsehen

Cerebras verkündet, dass die Lösung 57-mal schneller als auf GPUs sein wird, aber keine spezifischen GPUs erwähnt werden. DeepSeek R1 wird in der Cerebras-Cloud laufen, wobei die Daten in den USA verbleiben.

Cerebras hat bekannt gegeben, dass sie DeepSeek unterstützen werde, genauer gesagt das R1 70B-Modell. Dieser Schritt erfolgt nachdem auch Groq und Microsoft bestätigt haben, dass sie den neuen KI-Anbieter in ihre Clouds integrieren werden. AWS und Google Cloud müssen dies noch tun, aber jeder kann das Open-Source-Modell überall, auch lokal ausführen.

Der KI-Inferenzchip-Spezialist wird DeepSeek R1 70B mit 1.600 Tokens/Sekunde betreiben, was angeblich 57-mal schneller ist als jeder andere Anbieter von R1 mit GPUs; man kann ableiten, dass die GPU-in-the-Cloud-Lösung (in diesem Fall DeepInfra) scheinbar 28 Tokens/Sekunde erreicht. Zufälligerweise ist Cerebras‘ neuester Chip 57-mal größer als der H100. Ich habe Cerebras kontaktiert, um mehr über diese Behauptung zu erfahren.

Die Forschung von Cerebras hat auch gezeigt, dass DeepSeek in einer Vielzahl von Tests genauer ist als die OpenAI-Modelle. Das Modell wird auf Cerebras-Hardware in US-amerikanischen Rechenzentren laufen, um Datensicherheitsbedenken zu lindern. DeepSeek – die App – wird Ihre Daten (und Metadaten) nach China senden, wo sie höchstwahrscheinlich gespeichert werden. Nichts Überraschendes hier, da fast alle Apps – insbesondere kostenlose – Benutzerdaten aus legitimen Gründen erfassen.

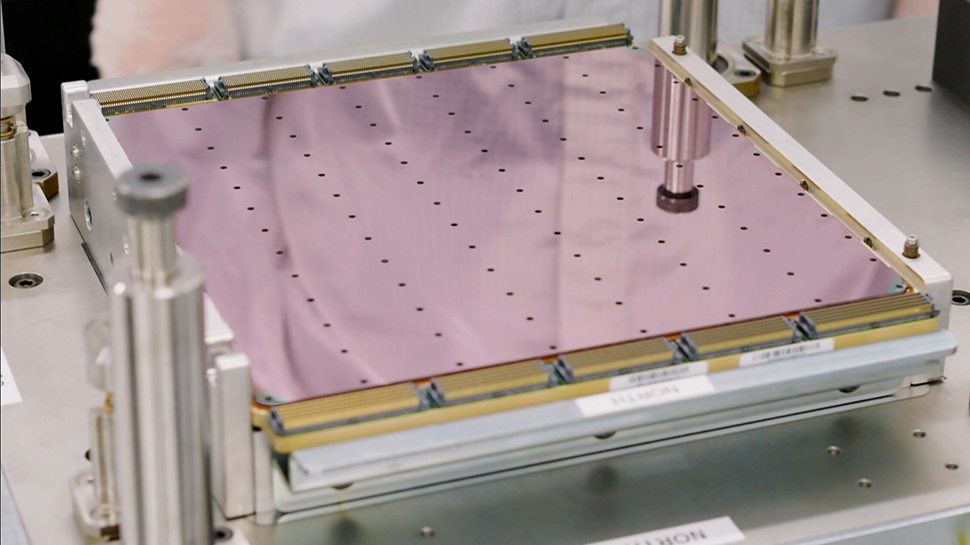

Cerebras‘ Wafer-Scale-Lösung positioniert sie einzigartig, um vom bevorstehenden KI-Cloud-Inferenz-Boom zu profitieren. WSE-3, der schnellste KI-Chip (oder HPC-Beschleuniger) der Welt, verfügt über fast eine Million Kerne und vier Billionen Transistoren. Noch wichtiger ist jedoch, dass er über 44 GB SRAM verfügt, was der schnellste verfügbare Speicher ist, sogar schneller als das auf Nvidias GPUs zu findende HBM. Da WSE-3 nur ein riesiger Chip ist, ist die verfügbare Speicherbandbreite enorm, um mehrere Größenordnungen größer als das, was der Nvidia H100 (und auch der H200) bieten können.

Ein Preiskrieg bahnt sich vor dem Start von WSE-4 an. Es wurden noch keine Preise bekannt gegeben, aber Cerebras, das normalerweise schweigsam über dieses spezielle Detail ist, gab letztes Jahr bekannt, dass Llama 3.1 405B auf Cerebras Inference 6 $/Million Input-Tokens und 12 $/Million Output-Tokens kosten würde. Man sollte erwarten, dass DeepSeek für wesentlich weniger verfügbar sein wird. WSE-4 ist die nächste Generation von WSE-3 und wird eine signifikante Leistungssteigerung für DeepSeek und ähnliche Modelle ermöglichen, wenn sie voraussichtlich 2026 oder 2027 auf den Markt kommen wird (abhängig von den Marktbedingungen).

Die Einführung von DeepSeek wird voraussichtlich auch den „AI-Geldbaum“ erschüttern, indem sie mehr Wettbewerb für etablierte Player wie OpenAI oder Anthropic bringt und die Preise senkt. Ein schneller Blick auf den Docsbot.ai LLM-API-Rechner zeigt, dass OpenAI in nahezu allen Konfigurationen fast immer am teuersten ist, manchmal um mehrere Größenordnungen.