Die KI-Revolution: Nvidia integriert DeepSeek-R1 als NIM-Mikrodienst

Tiefgründige Integration von DeepSeek-R1 durch Nvidia als NIM-Mikrodienst

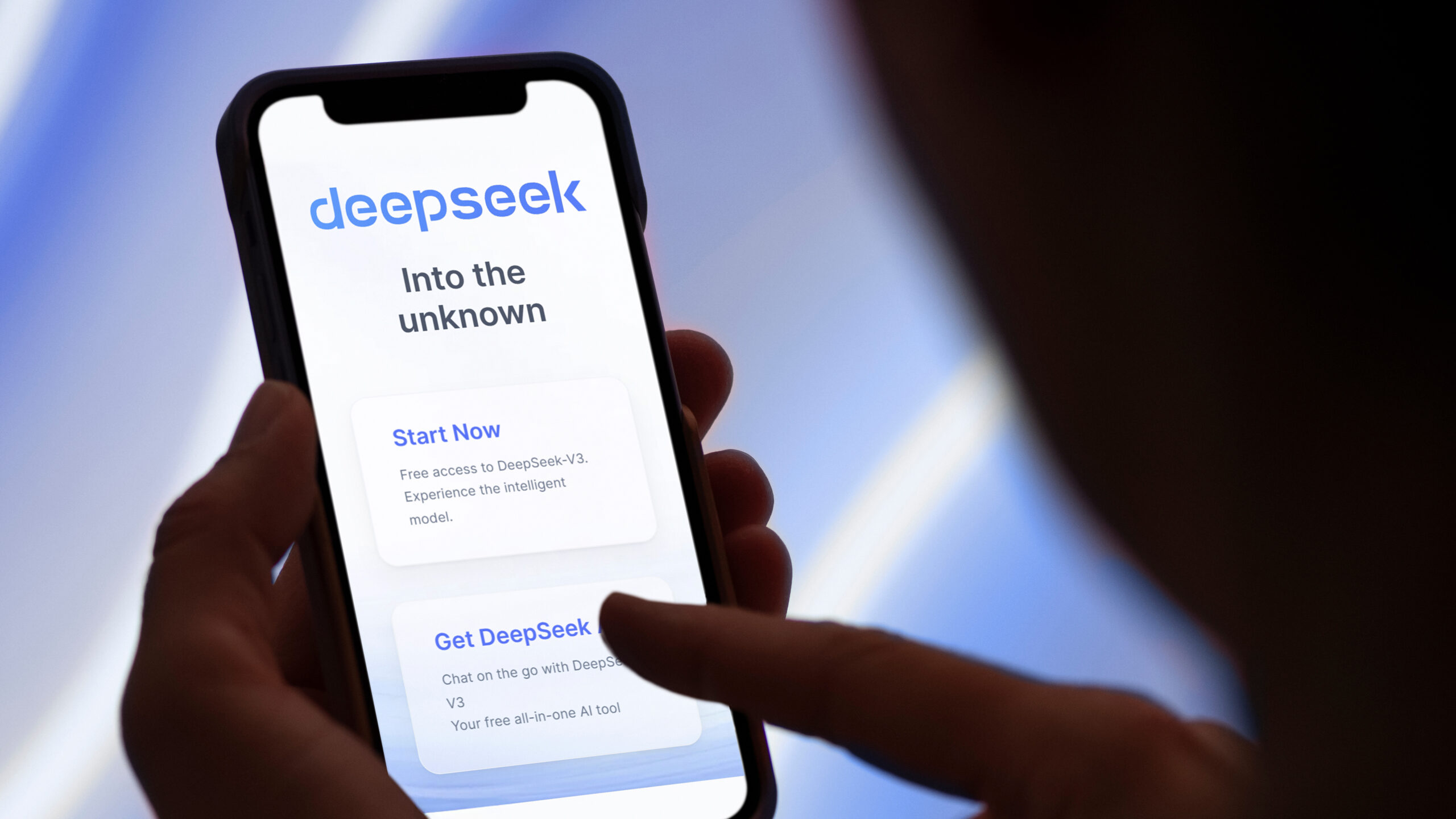

Die KI-Welt wurde in den letzten Wochen von DeepSeek im Sturm erobert und hat nun große Fortschritte gemacht, um den Zugang zu ihren fortschrittlichen Denkmodellen zu erweitern. Der Flaggschiff DeepSeek R1 ist jetzt auf verschiedenen Plattformen wie Nvidia, AWS und GitHub verfügbar.

Nvidia, AWS, Github und Azure bieten nun DeepSeek an. Auf AWS sind DeepSeek-R1-Modelle jetzt über Amazon Bedrock zugänglich, was die API-Integration vereinfacht. Amazon SageMaker ermöglicht eine fortschrittliche Anpassung und Schulung, unterstützt von AWS Trainium und Inferentia für eine optimierte Kosteneffizienz. AWS bietet auch DeepSeek-R1-Distill, eine leichtere Version, über Amazon Bedrock Custom Model Import an. Diese serverlose Bereitstellung vereinfacht das Infrastrukturmanagement bei gleichzeitiger Skalierbarkeit.

Nvidia hat DeepSeek-R1 auch als NIM-Mikrodienst integriert und nutzt seine Hopper-Architektur sowie die FP8-Transformer-Engine-Beschleunigung, um Echtzeit- und qualitativ hochwertige Antworten zu liefern. Dieses Modell, das über 671 Milliarden Parameter und eine Kontextlänge von 128.000 Token verfügt, nutzt die Testzeitskalierung für verbesserte Genauigkeit. Es profitiert auch von der Hopper-Architektur von Nvidia, die die FP8-Transformer-Engine-Beschleunigung und die NVLink-Konnektivität nutzt.

Microsofts Azure AI Foundry und GitHub haben außerdem die Reichweite von DeepSeek erweitert und bieten Entwicklern eine sichere und skalierbare Plattform zur Integration von KI in ihre Workflows. Microsoft hat auch umfangreiche Sicherheitsmaßnahmen implementiert, einschließlich Inhaltsfilterung und automatisierter Bewertungen. Das Unternehmen gibt an, dass es in Zukunft distillierte Versionen von DeepSeek-R1 für die lokale Bereitstellung auf Copilot+ PCs anbieten wird.

DeepSeek-R1 hat die Welt durch ein leistungsstarkes, kosteneffizientes KI-Modell mit fortschrittlichen Denkfähigkeiten im Sturm erobert und beliebte KI-Modelle wie ChatGPT entthront. R1 wurde angeblich für nur 6 Millionen Dollar trainiert, wobei seine fortgeschrittensten Versionen etwa 95% günstiger im Training sind als vergleichbare Modelle von NVIDIA und Microsoft.